ICT の多様化により、そこで生み出される情報量が爆発的に増えている情報爆発の時代を、私たちは生きている。呼吸するように、インターネットから情報と知識を得ている。呼吸していることを自覚することが稀であるように、その情報や知識がなぜインターネットから得られるのか、考えたことがないのがほとんどだろう。

Google検索の結果得られる情報や知識は、検索対象となるようあらかじめ準備されている。つまり「機械が読める(machine readable)」状態に加工が施されていてはじめて、検索の対象となり、検索結果として表示される。

新聞、雑誌、書籍から人間が目で活字や図画を追うことで「読める」のとは違う、「機械が読める」状態への加工が必要なのだ。たとえば文字にはひとつひとつコードが振られていなくてはならない。その文字列がその文章のタイトルなのであれば、タイトルであると機械がわかるようタグを付与しておかなければならない。

日本語の抱えるハンディキャップ

この、「機械が読める」に関して、日本語は英語と比べハンデを背負い込んでいる。列挙すると以下の四つとなる。

イ.文字数が多い

ロ.単語の判別が難しい

ハ.文節の理解が難しい

ニ.本のデジタルデータが少ない

アルファベット26文字の英語と、かなと漢字を足すと数千文字を普段から使っている日本語。さらに日本語の場合同じ漢字でも、字体が異なる文字があり「万」の単位の文字コードが必要となる。つまり英語と日本語とでは、用意しておかなければならない文字コードの数が断然異なるということになる。

ただこのイ.は、情報端末の記憶容量が各段に増強されたことでだいぶ状況は改善してきた。(たとえば以前は、「トウショウヘイ」は「とう小平」としか表現できなかったが、最近は「鄧小平」と表示できるようになった)

難問はロ.ハ.だ。

イ.文字数が多い

ロ.単語の判別が難しい

ハ.文節の理解が難しい

ニ.本のデジタルデータが少ない

文字にひとつひとつコードを振ったように、単語にもコードを振って、そこへ属性(名詞か動詞か、単数か複数かなど)を記述しておけば文法と照らし合わせ、機械が、検索窓からの問い合わせ(クエリ)に対し、適切な解となりうる候補テキストをネット上の膨大なデータから探し出すのに、便利だろう。

検索が効率的に、効果的に結果を表示するにはこの単語の判別、文節の理解といった、いわゆる形態素解析という工程が欠かせないのだ。

この観点で英語が有利、日本語が不利だというのはテキスト(文章)の具体例を見たほうがわかりやすい。

“Books can seek to engage the next generation on their phones as well as in print.

E-reader use is declining while phones offer countless new ways to construct narrative and read deeply. These are books that can compete for attention on your phone via incredible, dynamic literature.”

(T. L. Uglow, Google’s Creative Lab ; Editions At Play: in Pictures より)

英語は単語と単語の間に空間が挟まっていて、単語の認識が簡単だ。しかし日本語はそうはいかない。

単語の判別が難しいと文節の理解も進まない。

文節の理解がないと、文章の内容の理解も、ひいてはクエリとそれへの回答との間の検索ユーザー満足にも支障が生じる。

Google検索が、その仕組みを意識せず、呼吸と同じくらい自然に利用されている状況で、実は英語と日本語とで検索の精度をあげるうえでの障害の差が大きい。このことは日常生活での検索だけでなく、「知の生成と流通」における情報探索にも関わる重大問題だろう。

人工知能とGoogle検索

「文章の内容の理解」といっても、検索窓からの問い合わせ(クエリ)とその応答は、原理的に当初はマッチングを基本としたうえで、高速処理ということに技術開発の努力が続けられていた。しかし検索ユーザーに満足を与えるには、マッチングだけでは限界がある。

Googleは1998年に検索事業をスタートさせたが、2005年から人工知能の機械学習機能を採用し始める。そして2015年、ディープラーニング研究の成果物である「RankBrain」導入を公表した。

ディープラーニングは機械の自律的な学習に道をひらく技術だ。変数の設定など、人間がやってはじめて機械学習における演算が始まるのとは異なるのが特徴である。ナレッジグラフの工夫と組み合わせ、検索エンジンが賢くなるスピードが加速している。

その技術の検索への採用結果、加速の現状は「検索ユーザーの真意を忖度することができるようになった」。正確には「ある単語を含まないクエリに対して、きちんと回答を出す」という現象として現れている。

「文章の内容の理解」にロ.ハ.のハンデを背負う日本語にとってまずは「朗報!」と受け止めていいだろう。

検索ユーザーの真意を忖度する様子は、具体例を見たほうがわかりやすい。英米のメディアが報じた例を紹介すると、こんな具合である。

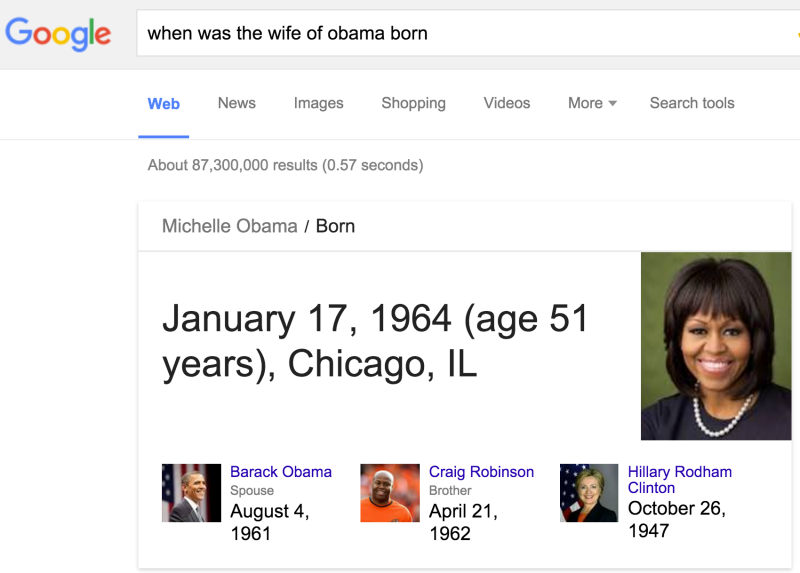

まず「オバマ夫人の誕生日は?」と、「ミシェル・オバマ」という単語の含まれていない質問をされても、ミシェル・オバマ氏のことを訊ねられたと理解し正しい回答を返している例だ(FAQ: All About The New Google RankBrain Algorithm, Search Engine Land, 2015年10月27日)。

(出典:上記記事)

GoogleのRankBrainについては「RankBrain(ランク・ブレイン)。人工知能は、既に、Googleの検索結果を処理している。」(SEO Japan、2015年10月27日)も参考になる。

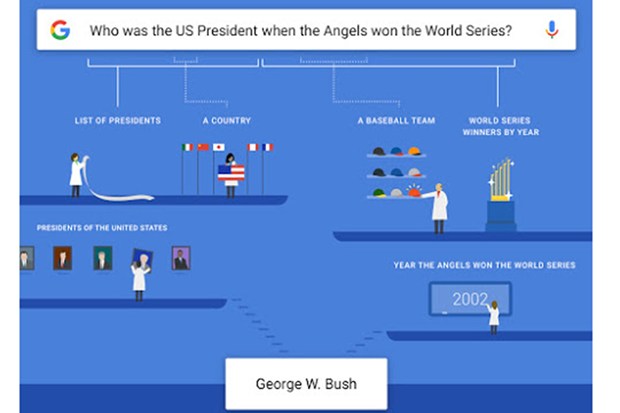

さらに複雑な「(ロサンゼルス・)エンゼルスがワールドシリーズで優勝したときの米国大統領は誰?」という質問に対し、どういうメカニズムがGoogle検索の裏側で作動しているかを、グーグル自身が下記の図のように解説している。

How Google answers complex questions. (出典: Inside Search: The Google app now understands you a little better—complex questions welcome )

2012年に導入した、個々の検索結果を拡張する知識データベース「ナレッジグラフ(Knowledge Graph)」と人工知能を連携させながら、質問文の各要素を単に理解するのではなく、質問の意味全体を理解できるようにしているのである(Wired.jpの記事「Google検索、英語版で「より長く、複雑な構文」のフレーズに対応」も参照のこと)。

Now we’re “growing up” just a little more. The Google app is starting to truly understand the meaning of what you’re asking. We can now break down a query to understand the semantics of each piece…

(大意)われわれは、クエリを分解して、それぞれの単語の意味を理解できるようになりました。いまでは、質問全体の背景にある意図も解釈できます。(Inside Search: The Google app now understands you a little better—complex questions welcome より)

機械の自律的な学習のための材料は豊富か?

ここで四番目の障害が登場する。

イ.文字数が多い

ロ.単語の判別が難しい

ハ.文節の理解が難しい

ニ.本のデジタルデータが少ない

Googleが格納するデータを原資として人工知能は学習する。その際、「本」の文章は体系化、構造化されていて、検索エンジンを人工知能を使って、より賢くするのに有用なデータ群だ。

その「本」のデータ数が、桁ふたつ、ひょっとすると三つくらい違う。英語と日本語では。英語圏には、とりわけ米国ではGoogleが米国著作権法に規定されている「フェアユース」条項のおかげで2000万冊以上の本のデータが格納されているからだ。

2009年のGoogle Books検索プロジェクト集団訴訟の和解案をめぐる大騒ぎのときに比べ、2015年のGoogle勝訴は、日本であまり大きく報じられることも議論されることもなかったように思う。しかしこの勝訴がもたらすインパクトは、彼我の「知の生成と流通」にきわめて大きな影響を与えると考えた方がよい。

2015年10月16日、ニューヨーク連邦高裁(連邦第二巡回区控訴裁判所)は、Googleの書籍全文検索サービスGoogle Booksがフェアユース(権利制限の一般規定)にあたるとのGoogleの主張を認めるとの判断を下した。

Google Booksプロジェクトは、「図書館プロジェクト」と、「パートナープログラム」のふたつで構成されている。

「図書館プロジェクト」は、国内外の大規模な図書館(国立・公立・大学図書館など)の蔵書をデジタル化するプロジェクトだ。デジタルデータは全文(パブリックドメインの場合)、あるいはスニペット(抜粋文)として検索結果に出てくる。このプロジェクトに賛同する図書館は、前提としてGoogleと提携契約を結ばなくてはならない。米国では多くの図書館が参加しているが、日本では慶応義塾大学のみである。

(提携図書館の一覧はこちら)

「パートナープログラム」では、著作者や出版社が、書籍のPRを目的としてGoogle Booksに書籍の情報を自分で登録・公開することができる。

ここで、検索結果に出るか出ないかという問題に加え、人工知能がディープラーニング技術を使って検索エンジンを賢くすることに使われることに注意を向けたい。

日本でGooglePlay(電子書籍などを販売するサイト)に提供されている有料コンテンツたる「本」の数は10万冊程度と推定される。これに慶応義塾大学から提供されたパブリックドメインの12万点が加わるが、とうてい百万冊を超えることはない。

それに対して2013年11月14日決定の裁判資料にはすでに次

被告(Google.Inc)は、2004年以来、複数の大学図書館等とその蔵書をスキャンすることに合意、2000万冊以上の書籍をスキャンした。そのうえで、書籍のデジタルコピーは参加した各図書館に配布、またデータベース化してオンライン上で検索するユーザーに対し、スニペット(ごく一部の抜粋)表示できるようにした。

Since 2004, when it announced agreements with several major research libraries to digitally copy books in their collections, defendant Google Inc.(“Google”) has scanned more than twenty million books. It has delivered digital copies to participating libraries, created an electronic database of books, and made text available for online searching through the use of “snippets.”

(NY州南部地区地方裁判所 2013年11月14日決定の裁判資料より

http://www.documentcloud.org/documents/834877-google-books-ruling-on-fair-use.html )

Google books Ngram Viewer

さてGoogleに、Google トレンドという検索ボリュームの推移を見るツールがあるのは有名だ(日本語にも対応)。しかしGoogle books Ngram Viewerは日本でほとんど知られていない(日本語未対応のためだろうか)。

Google books Ngram Viewerは、GoogleBooksプロジェクトでデジタル化されたデータ、大量の「本」を検索して、文学書やそのほかの本に現れる言葉の流行り廃りを、時系列の折れ線グラフで見ることができるサービスだ。デフォルトの画面では、1800年から2000年までが調べられるようになっている。

これも具体例を提示しよう。

まず「fax, phone, e-mail」。

次に「pizza, steak, sushi」。

最後に「modern state, Welfare State」

膨大な既刊書にOCRをかけたテキストデータがあればこそのサービスだ。

こうしたGoogleのサービスを面白がってばかりはいられない。人工知能がディープラーニング技術を使って検索エンジンを賢くすることに使われ、その作業のベースに数千万の「本」のデータがある言語とそうでない言語の、知の生産性の開きが、ほとんど意識されていないところでどんどん広がっていることに、もっと危機感を抱くべきだ。

Googleとの積極的な提携を

彼我の差を縮めるうえで鍵を握るのは国立国会図書館だろう。

2009年、「平成の大改正」と呼ばれる著作権法の改正が行われたが、その中で国立国会図書館における所蔵資料の電子化(第31条)が盛り込まれた。

すなわち第31条「図書館等における複製」の条文に「第2項」という形で条文が追加され、権利者の許諾を得ることなく図書館資料の原本をデジタル化することが国立国会図書館に対して認められたのである。

国立国会図書館には法定納本制度があり、全国の出版社は新刊を出した際、1冊を納本する義務がある。これら納本された日本の出版物を、国立国会図書館でデジタル化するところまでは、2009年の改正ですでに著者許諾を得ずに行うことが認められていた。ただしこのときは、デジタル化されたデータの利活用は館内での閲覧や複写サービスなどに使われることが前提となっていた。

2014年の著作権法改正ではそこからさらに一歩進み、情報提供施設として図書館が果たす重要性を踏まえて、「利用者への情報提供などその有効活用を図るべき」との国会での附帯決議もあり、デジタル化資料の一部を大学図書館や公共図書館にネット送信することも認められた。

いまから「国産Google」を開発するのは現実的ではない。むしろGoogleと積極的に提携し、

1.日本語検索の仕組みのレベルアップのためにだけ使うことを内容とする業務契約を、国立国会図書館との間で締結し、Googleによるデータ活用を認める(デジタル化費用はGoogle側が負担)。

2.さらに進んで、スニペット表示までの検索結果をも許容する。

といったことを、日本語における「知の生成と流通」の高度化のために大胆に構想することが必要なのではないだろうか。

※この記事は「ちえのたね|詩想舎」の2016年2月7日のエントリー「日本語のハンデと人工知能とGoogleBooks訴訟」に編集を加えて転載したものです。

執筆者紹介

- 元銀行員。事業調査、融資個別審査、融資企画などを担当。また信用リスク計量化システム構築の責任者を務めた。2003年、出版業界へ転籍。そこで総務、企画編集、制作、営業を経験した後、現在はデジタル化推進を担当している。

ちえのたね|詩想舎

最近投稿された記事

- 2016.02.12コラム機械が「読む」時代の知に対応するために